LLM không còn là khái niệm nghiên cứu hàn lâm, mà đã trở thành “bộ não” của Gen AI trong doanh nghiệp và khu vực công. Bài viết này giúp bạn hiểu đúng LLM là gì, vì sao Transformer tạo nên bước ngoặt lịch sử, LLM đang được triển khai ra sao tại Việt Nam và đâu là những lưu ý chiến lược khi ứng dụng trong giai đoạn 2025–2027.

LLM là gì?

LLM (Large Language Model – Mô hình Ngôn ngữ Lớn) là các mô hình mạng nơ-ron sâu quy mô rất lớn, được huấn luyện trên hàng tỷ đến hàng nghìn tỷ token, nhằm hiểu, tạo và suy luận trên ngôn ngữ con người với độ linh hoạt cao.

Tôi thường nói với khách hàng rằng:

LLM không chỉ “biết nói”, mà là “biết suy nghĩ bằng ngôn ngữ xác suất”.

Vì sao câu hỏi “llm là gì” trở nên then chốt năm 2025?

“LLM là gì” không còn là câu hỏi học thuật, mà là câu hỏi chiến lược đối với doanh nghiệp, chính phủ và hệ thống giáo dục.

Dữ liệu đã được kiểm chứng

- Giai đoạn 2020–2024, quy mô tham số LLM tăng hơn 100 lần

- Theo nghiên cứu Scaling Laws, hiệu năng LLM tăng theo lũy thừa khi mở rộng tham số (N), dữ liệu (D) và compute (C)

- Năm 2025, hơn 80% hệ thống Gen AI trong doanh nghiệp lớn sử dụng LLM làm lõi suy luận

Trong 10 năm tư vấn chuyển đổi số, tôi chưa từng thấy công nghệ nào tái cấu trúc lại lao động tri thức nhanh như LLM.

Lịch sử phát triển từ ELIZA đến kỷ nguyên Transformer

LLM là kết quả của hơn 60 năm tiến hóa trong xử lý ngôn ngữ tự nhiên (NLP).

Các mốc then chốt

| Giai đoạn | Công nghệ | Đặc trưng |

| 1960s | ELIZA | Đối sánh mẫu, không hiểu ngữ cảnh |

| 1990s | RNN / LSTM | Nhớ chuỗi ngắn, gặp vanishing gradient |

| 2017 | Transformer | Self-Attention, xử lý song song |

| 2020–nay | LLM | Pre-training + RLHF + Reasoning |

Kiến trúc Transformer (nền móng của LLM hiện đại)

Transformer là kiến trúc cho phép mô hình hiểu toàn bộ ngữ cảnh cùng lúc, thay vì đọc từng từ tuần tự.

Self-Attention là gì?

Self-Attention cho phép mỗi token:

- Đặt “câu hỏi” (Query)

- So khớp với “khóa” (Key)

- Tổng hợp thông tin (Value)

Công thức chuẩn:

Attention(Q,K,V) = softmax(QKᵀ / √dk) × V

Vì sao Multi-Head Attention quan trọng?

- Mỗi “head” học một khía cạnh ngữ nghĩa khác nhau

- Có head hiểu ngữ pháp, head hiểu logic, head hiểu ngữ cảnh xã hội

Khi tôi triển khai LLM cho hệ thống trợ lý hành chính, Multi-Head Attention giúp AI hiểu được cả ngôn ngữ pháp lý lẫn văn phong công vụ – điều các mô hình cũ không làm được.

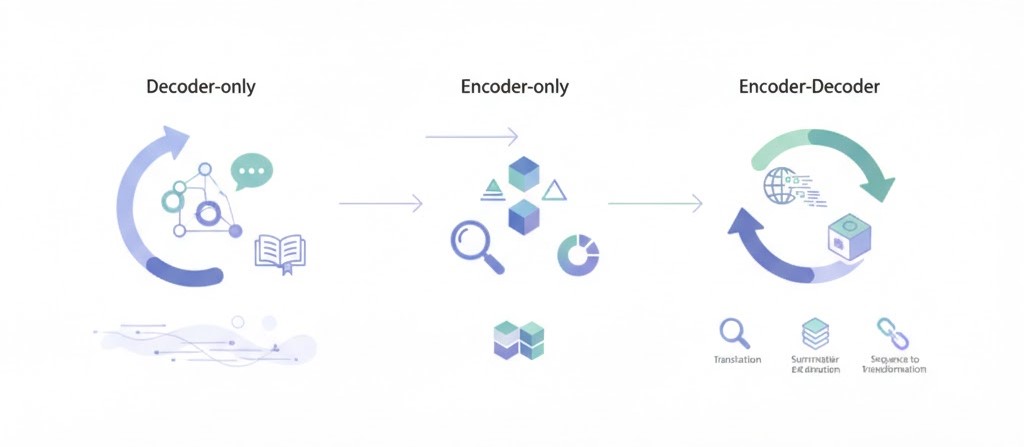

Các biến thể LLM phổ biến hiện nay

Không phải LLM nào cũng giống nhau – kiến trúc quyết định năng lực.

Ba nhánh chính

- Decoder-only (GPT, Llama, Claude)

→ Tối ưu sinh văn bản, hội thoại - Encoder-only (BERT)

→ Tối ưu hiểu, phân loại, trích xuất - Encoder-Decoder (T5, BART)

→ Dịch máy, tóm tắt, chuyển đổi chuỗi

Vì sao huấn luyện LLM cực kỳ tốn kém?

Huấn luyện LLM là quá trình nén tri thức nhân loại vào trọng số mô hình.

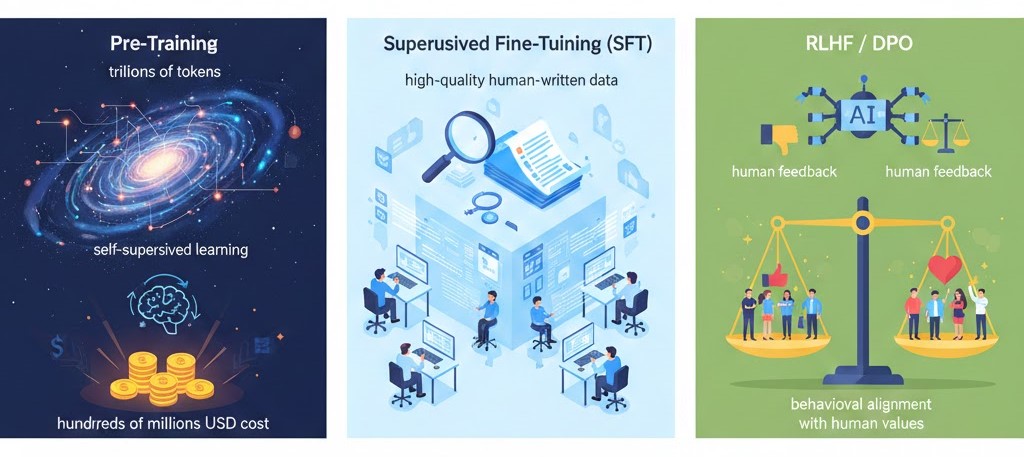

3 giai đoạn cốt lõi

- Pre-training

- Hàng nghìn tỷ token

- Học tự giám sát

- Chi phí hàng trăm triệu USD

- Supervised Fine-Tuning (SFT)

- Dữ liệu chất lượng cao do con người viết

- RLHF / DPO

- Căn chỉnh hành vi theo giá trị con người

“AI không tự nhiên an toàn – nó phải được căn chỉnh” — Stuart Russell, Đại học Berkeley

Mô hình suy luận (Reasoning LLM)

Reasoning LLM là mô hình đầu tư thêm compute tại thời điểm suy luận, thay vì chỉ “phản xạ tức thì”.

Test-time Compute Scaling là gì?

- Cho phép AI:

- Suy nghĩ lâu hơn

- Tự kiểm tra

- Quay lại sửa sai

Các mô hình như o1, o3, DeepSeek R1 cho thấy:

- Điểm toán AIME tăng vượt bậc

- Giải quyết bài code phức tạp tốt hơn GPT truyền thống

Doanh nghiệp nên chọn LLM đóng hay LLM mở

Không có lựa chọn “tốt nhất”, chỉ có phù hợp nhất.

So sánh nhanh

| Tiêu chí | LLM đóng | LLM mở |

| Hiệu năng | Rất cao | Tiệm cận |

| Chi phí dài hạn | Cao | Thấp |

| Chủ quyền dữ liệu | Thấp | Cao |

| Tuỳ chỉnh | Hạn chế | Linh hoạt |

Trong các dự án VN168, tôi thường:

- LLM đóng cho thử nghiệm nhanh

- LLM mở + fine-tune/RAG cho vận hành lâu dài

Kết luận

LLM là nền tảng trí tuệ trung tâm của Gen AI, quyết định năng lực suy luận, sáng tạo và tự động hóa của hệ thống AI hiện đại.

Khuyến nghị của tôi cho giai đoạn 2025–2027

- Làm chủ dữ liệu & hạ tầng

- Ưu tiên LLM mở + nội địa hóa

- Đào tạo con người làm việc cùng LLM

- Xây dựng khung quản trị AI có trách nhiệm

LLM sẽ không thay thế con người.

Nhưng người hiểu LLM sẽ thay thế người không hiểu.

- AI Marketing là gì? Tìm Hiểu về Ứng Dụng Trí Tuệ Nhân Tạo trong Marketing

- AI tạo sinh là gì? Nền tảng công nghệ làm thay đổi thế giới số

- Mã QR Code hoạt động thế nào? Giải thích đơn giản dễ hiểu

- Mã QR hết hạn phải làm sao? thời hạn mã QR là bao lâu?

- Trí tuệ nhân tạo có trách nhiệm (Responsible AI) là gì? 5 trụ cột cốt lõi